728x90

반응형

* 주피터 노트북에서 실행하였다.

import requests

만약 실행되지 않는다면 주피터 노트북 상에서 설치하는 방법이 있다.

!pip install requests

pwd #현재 위치

import requests as rq

url = "https://hello-ming.tistory.com/"

res=rq.get(url) #get방식으로 접근

print(res) # <Response [200]>

rq.post(url) # <Response [200]>

res.status_code # 200

def url_check(url):

res = rq.get(url)

print(res)

sc = res.status_code

if sc==200:

print("%s 요청 성공"%(url))

elif sc==404:

print("%s 알 수 없는 에러 "%(url))

else:

print("%s 알 수 없는 에러:%s "%(url,sc))

headers=res.headers #헤더들을 가져온다.

headers

type(headers)

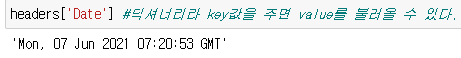

headers['Date'] #딕셔너리라 key값을 주면 value를 불러올 수 있다.

#반복문을 이용하여 항목 출력

for i in headers:

print('1) key : ',i,' 2) values : ',headers[i])

728x90

반응형

'Data Analysis > web crawling' 카테고리의 다른 글

| [crawling] requests vs urllib / 파싱모듈 (0) | 2021.06.08 |

|---|---|

| [Crawling] 크롤링 get요청, post요청하기 (0) | 2021.06.07 |

| [Crawling] 데이터 보내는 방법 (0) | 2021.06.07 |

| [Crawling] html코드를 가져오기 (0) | 2021.06.07 |

| [Crawling] 크롤링 시작 / url을 html파일로 바꾸기 (1) | 2021.06.04 |